How to protect your AI systems against adversarial machine learning

مع تزايد شعبية التعلم الآلي، فإن الشيء الوحيد الذي كان يقلق الخبراء هو التهديدات الأمنية التي ستترتب على التكنولوجيا. ما زلنا نستكشف الاحتمالات: تعطل أنظمة القيادة الذاتية؟ سرقة غير واضحة لبيانات حساسة من شبكات عصبية عميقة؟ فشل المصادقة البيومترية القائمة على التعلم العميق؟ تجاوز دقيق لخوارزميات تعديل المحتوى؟

وفي الوقت نفسه، وجدت خوارزميات التعلم الآلي طريقها بالفعل إلى مجالات مهمة مثل التمويل والرعاية الصحية والنقل، حيث يمكن أن يكون للفشل الأمني تداعيات خطيرة.

بالتوازي مع زيادة اعتماد خوارزميات التعلم الآلي في مجالات مختلفة، كان هناك اهتمام متزايد بالتعلم الآلي عن طريق الخصم، وهو مجال البحث الذي يستكشف الطرق التي يمكن من خلالها اختراق خوارزميات التعلم.

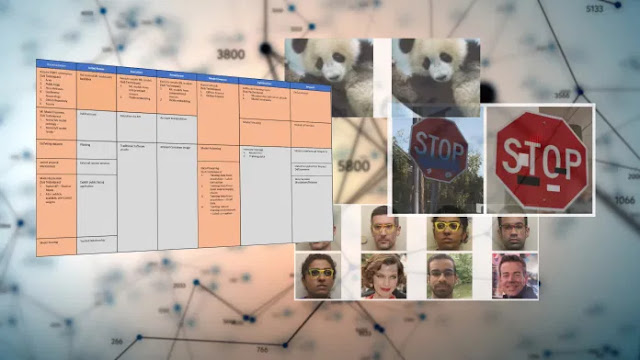

والآن، لدينا أخيرًا إطار عمل لاكتشاف الهجمات العدائية ضد أنظمة التعلم الآلي والاستجابة لها. يُطلق على إطار العمل المسمى Adversarial ML Threat Matrix، وهو نتيجة جهد مشترك بين باحثي الذكاء الاصطناعي في 13 مؤسسة، بما في ذلك Microsoft و IBM و Nvidia و MITER.

بينما لا تزال في مراحلها الأولى، توفر مصفوفة ML Threat Matrix نظرة موحدة لكيفية استفادة الجهات الخبيثة من نقاط الضعف في خوارزميات التعلم الآلي لاستهداف المؤسسات التي تستخدمها. وتتمثل رسالتها الرئيسية في أن تهديد التعلم الآلي العدائي حقيقي ويجب على المؤسسات العمل الآن لتأمين أنظمة الذكاء الاصطناعي الخاصة بها.

وفي الوقت نفسه، وجدت خوارزميات التعلم الآلي طريقها بالفعل إلى مجالات مهمة مثل التمويل والرعاية الصحية والنقل، حيث يمكن أن يكون للفشل الأمني تداعيات خطيرة.

بالتوازي مع زيادة اعتماد خوارزميات التعلم الآلي في مجالات مختلفة، كان هناك اهتمام متزايد بالتعلم الآلي عن طريق الخصم، وهو مجال البحث الذي يستكشف الطرق التي يمكن من خلالها اختراق خوارزميات التعلم.

والآن، لدينا أخيرًا إطار عمل لاكتشاف الهجمات العدائية ضد أنظمة التعلم الآلي والاستجابة لها. يُطلق على إطار العمل المسمى Adversarial ML Threat Matrix، وهو نتيجة جهد مشترك بين باحثي الذكاء الاصطناعي في 13 مؤسسة، بما في ذلك Microsoft و IBM و Nvidia و MITER.

بينما لا تزال في مراحلها الأولى، توفر مصفوفة ML Threat Matrix نظرة موحدة لكيفية استفادة الجهات الخبيثة من نقاط الضعف في خوارزميات التعلم الآلي لاستهداف المؤسسات التي تستخدمها. وتتمثل رسالتها الرئيسية في أن تهديد التعلم الآلي العدائي حقيقي ويجب على المؤسسات العمل الآن لتأمين أنظمة الذكاء الاصطناعي الخاصة بها.

تطبيق ATT & CK على التعلم الآلي

يتم تقديم مصفوفة تهديدات ML Threat بأسلوب ATT & CK، وهو إطار عمل تم تجربته واختباره تم تطويره بواسطة MITER للتعامل مع التهديدات الإلكترونية في شبكات المؤسسات. يوفر ATT & CK جدولًا يلخص التكتيكات العدائية المختلفة وأنواع التقنيات التي يؤديها الفاعلون المهددون في كل منطقة.

منذ إنشائها، أصبحت ATT & CK دليلًا شائعًا لخبراء الأمن السيبراني ومحللي التهديدات للعثور على نقاط الضعف والتكهن بالهجمات المحتملة. يسهّل تنسيق ATT & CK لمصفوفة Adversarial ML Threat Matrix على محللي الأمان فهم تهديدات أنظمة التعلم الآلي. وهو أيضًا مستند يمكن الوصول إليه لمهندسي التعلم الآلي الذين قد لا يكونون على دراية تامة بعمليات الأمن السيبراني.

قال Pin-Yu Chen، باحث الذكاء الاصطناعي في IBM، لـ TechTalks في تعليقات مكتوبة: "تخضع العديد من الصناعات للتحول الرقمي ومن المرجح أن تتبنى تقنية التعلم الآلي كجزء من عروض الخدمات/ المنتجات، بما في ذلك اتخاذ قرارات عالية المخاطر". "لقد تطور مفهوم" النظام "وأصبح أكثر تعقيدًا مع اعتماد التعلم الآلي والتعلم العميق."

على سبيل المثال، يقول Chen، يمكن أن تتغير توصية طلب القرض المالي الآلي من نظام شفاف قائم على القواعد إلى نظام الصندوق الأسود المعتمد على الشبكة العصبية، والذي قد يكون له آثار كبيرة على كيفية مهاجمة النظام وتأمينه.

يقول Chen: "إن تحليل مصفوفة التهديد العدائي (أي الدراسة) يسد الفجوة من خلال تقديم نظرة شاملة للأمن في الأنظمة الناشئة القائمة على ML، وكذلك توضيح أسبابها من خلال الوسائل التقليدية والمخاطر الجديدة التي يسببها ML".

تجمع مصفوفة الخصم ML Threat Matrix بين التكتيكات والتقنيات المعروفة والموثقة المستخدمة في مهاجمة البنية التحتية الرقمية مع الأساليب الفريدة لأنظمة التعلم الآلي. مثل جدول ATT & CK الأصلي، يمثل كل عمود تكتيكًا واحدًا (أو منطقة نشاط) مثل الاستطلاع أو التهرب من النموذج، وتمثل كل خلية تقنية محددة.

على سبيل المثال، لمهاجمة نظام التعلم الآلي، يجب على الفاعل الخبيث أولاً جمع معلومات حول النموذج الأساسي (عمود الاستطلاع). يمكن القيام بذلك من خلال جمع معلومات مفتوحة المصدر (أوراق arXiv، ومستودعات GitHub، والبيانات الصحفية، وما إلى ذلك) أو من خلال تجربة واجهة برمجة التطبيقات التي تعرض النموذج.

على سبيل المثال، يقول Chen، يمكن أن تتغير توصية طلب القرض المالي الآلي من نظام شفاف قائم على القواعد إلى نظام الصندوق الأسود المعتمد على الشبكة العصبية، والذي قد يكون له آثار كبيرة على كيفية مهاجمة النظام وتأمينه.

يقول Chen: "إن تحليل مصفوفة التهديد العدائي (أي الدراسة) يسد الفجوة من خلال تقديم نظرة شاملة للأمن في الأنظمة الناشئة القائمة على ML، وكذلك توضيح أسبابها من خلال الوسائل التقليدية والمخاطر الجديدة التي يسببها ML".

تجمع مصفوفة الخصم ML Threat Matrix بين التكتيكات والتقنيات المعروفة والموثقة المستخدمة في مهاجمة البنية التحتية الرقمية مع الأساليب الفريدة لأنظمة التعلم الآلي. مثل جدول ATT & CK الأصلي، يمثل كل عمود تكتيكًا واحدًا (أو منطقة نشاط) مثل الاستطلاع أو التهرب من النموذج، وتمثل كل خلية تقنية محددة.

على سبيل المثال، لمهاجمة نظام التعلم الآلي، يجب على الفاعل الخبيث أولاً جمع معلومات حول النموذج الأساسي (عمود الاستطلاع). يمكن القيام بذلك من خلال جمع معلومات مفتوحة المصدر (أوراق arXiv، ومستودعات GitHub، والبيانات الصحفية، وما إلى ذلك) أو من خلال تجربة واجهة برمجة التطبيقات التي تعرض النموذج.

تعقيد أمن التعلم الآلي

تم تضمين نقاط الضعف العدائية بعمق في العديد من معلمات نماذج التعلم الآلي، مما يجعل من الصعب اكتشافها باستخدام أدوات الأمان التقليدية.

يأتي كل نوع جديد من التكنولوجيا مع تداعياته الفريدة على الأمان والخصوصية. على سبيل المثال، أدى ظهور تطبيقات الويب ذات الخلفية لقاعدة البيانات إلى إدخال مفهوم حقن SQL. أدت لغات البرمجة النصية للمتصفح مثل JavaScript إلى هجمات البرمجة النصية عبر المواقع. قدم إنترنت الأشياء (IoT) طرقًا جديدة لإنشاء شبكات الروبوت وشن هجمات رفض الخدمة الموزعة (DDoS). تعمل الهواتف الذكية وتطبيقات الأجهزة المحمولة على إنشاء ناقلات هجوم جديدة للجهات الفاعلة الخبيثة ووكالات التجسس.

لقد تطور المشهد الأمني ولا يزال يتطور لمواجهة كل من هذه التهديدات. لدينا برامج لمكافحة البرامج الضارة، وجدران حماية لتطبيقات الويب، وأنظمة كشف التسلل والوقاية، وحلول حماية DDoS، والعديد من الأدوات الأخرى لدرء هذه التهديدات.

على سبيل المثال، يمكن لأدوات الأمان مسح الملفات التنفيذية الثنائية بحثًا عن البصمات الرقمية للحمولات الضارة، ويمكن للتحليل الثابت العثور على نقاط الضعف في كود البرنامج. قامت العديد من الأنظمة الأساسية مثل GitHub و Google App Store بالفعل بدمج العديد من هذه الأدوات وتقوم بعمل جيد في العثور على ثغرات أمنية في البرامج التي تستضيفها.

ولكن في الهجمات العدائية، يكون السلوك الضار ونقاط الضعف متأصلة بعمق في الآلاف والملايين من معلمات الشبكات العصبية العميقة، والتي يصعب العثور عليها وتتجاوز قدرات أدوات الأمان الحالية.

يقول Chen: "لا يتضمن أمان البرامج التقليدي عادةً مكون التعلم الآلي لأنه جزء جديد في النظام المتنامي"، مضيفًا أن اعتماد التعلم الآلي في المشهد الأمني يعطي رؤى جديدة وتقييمًا للمخاطر.

تأتي مصفوفة تهديدات ML الخاصة بالخصم مع مجموعة من دراسات الحالة للهجمات التي تنطوي على نقاط ضعف أمنية تقليدية ، والتعلم الآلي للخصم، ومجموعات من كليهما. المهم هو أنه خلافًا للاعتقاد الشائع بأن الهجمات العدائية مقصورة على البيئات المختبرية، تُظهر دراسات الحالة أن نظام التعلم الآلي للإنتاج يمكن أن يتعرض للخطر من خلال الهجمات العدائية.

على سبيل المثال، في دراسة حالة واحدة ، استخدم فريق الأمان في Microsoft Azure بيانات مفتوحة المصدر لجمع معلومات حول نموذج التعلم الآلي المستهدف. ثم استخدموا حسابًا صالحًا في الخادم للحصول على نموذج التعلم الآلي وبيانات التدريب الخاصة به. استخدموا هذه المعلومات للعثور على نقاط ضعف خصومة في النموذج وتطوير هجمات ضد واجهة برمجة التطبيقات التي كشفت وظائفها للجمهور.

يأتي كل نوع جديد من التكنولوجيا مع تداعياته الفريدة على الأمان والخصوصية. على سبيل المثال، أدى ظهور تطبيقات الويب ذات الخلفية لقاعدة البيانات إلى إدخال مفهوم حقن SQL. أدت لغات البرمجة النصية للمتصفح مثل JavaScript إلى هجمات البرمجة النصية عبر المواقع. قدم إنترنت الأشياء (IoT) طرقًا جديدة لإنشاء شبكات الروبوت وشن هجمات رفض الخدمة الموزعة (DDoS). تعمل الهواتف الذكية وتطبيقات الأجهزة المحمولة على إنشاء ناقلات هجوم جديدة للجهات الفاعلة الخبيثة ووكالات التجسس.

لقد تطور المشهد الأمني ولا يزال يتطور لمواجهة كل من هذه التهديدات. لدينا برامج لمكافحة البرامج الضارة، وجدران حماية لتطبيقات الويب، وأنظمة كشف التسلل والوقاية، وحلول حماية DDoS، والعديد من الأدوات الأخرى لدرء هذه التهديدات.

على سبيل المثال، يمكن لأدوات الأمان مسح الملفات التنفيذية الثنائية بحثًا عن البصمات الرقمية للحمولات الضارة، ويمكن للتحليل الثابت العثور على نقاط الضعف في كود البرنامج. قامت العديد من الأنظمة الأساسية مثل GitHub و Google App Store بالفعل بدمج العديد من هذه الأدوات وتقوم بعمل جيد في العثور على ثغرات أمنية في البرامج التي تستضيفها.

ولكن في الهجمات العدائية، يكون السلوك الضار ونقاط الضعف متأصلة بعمق في الآلاف والملايين من معلمات الشبكات العصبية العميقة، والتي يصعب العثور عليها وتتجاوز قدرات أدوات الأمان الحالية.

يقول Chen: "لا يتضمن أمان البرامج التقليدي عادةً مكون التعلم الآلي لأنه جزء جديد في النظام المتنامي"، مضيفًا أن اعتماد التعلم الآلي في المشهد الأمني يعطي رؤى جديدة وتقييمًا للمخاطر.

تأتي مصفوفة تهديدات ML الخاصة بالخصم مع مجموعة من دراسات الحالة للهجمات التي تنطوي على نقاط ضعف أمنية تقليدية ، والتعلم الآلي للخصم، ومجموعات من كليهما. المهم هو أنه خلافًا للاعتقاد الشائع بأن الهجمات العدائية مقصورة على البيئات المختبرية، تُظهر دراسات الحالة أن نظام التعلم الآلي للإنتاج يمكن أن يتعرض للخطر من خلال الهجمات العدائية.

على سبيل المثال، في دراسة حالة واحدة ، استخدم فريق الأمان في Microsoft Azure بيانات مفتوحة المصدر لجمع معلومات حول نموذج التعلم الآلي المستهدف. ثم استخدموا حسابًا صالحًا في الخادم للحصول على نموذج التعلم الآلي وبيانات التدريب الخاصة به. استخدموا هذه المعلومات للعثور على نقاط ضعف خصومة في النموذج وتطوير هجمات ضد واجهة برمجة التطبيقات التي كشفت وظائفها للجمهور.

تُظهر دراسات حالة أخرى كيف يمكن للمهاجمين اختراق جوانب مختلفة من خط أنابيب التعلم الآلي ومجموعة البرامج لتنفيذ هجمات تسمم البيانات، أو تجاوز أجهزة الكشف عن البريد العشوائي، أو إجبار أنظمة الذكاء الاصطناعي على الكشف عن معلومات سرية.

يمكن للمصفوفة ودراسات الحالة هذه توجيه المحللين في العثور على نقاط ضعف في برامجهم ويمكن أن توجه بائعي أدوات الأمان في إنشاء أدوات جديدة لحماية أنظمة التعلم الآلي.

يقول Chen: "إن فحص بُعد واحد (التعلم الآلي مقابل أمان البرامج التقليدية) يوفر فقط تحليلًا أمنيًا غير مكتمل للنظام ككل". "مثلما يقول المثل القديم: الأمن قوي بقدر قوة أضعف حلقاته".

يمكن للمصفوفة ودراسات الحالة هذه توجيه المحللين في العثور على نقاط ضعف في برامجهم ويمكن أن توجه بائعي أدوات الأمان في إنشاء أدوات جديدة لحماية أنظمة التعلم الآلي.

يقول Chen: "إن فحص بُعد واحد (التعلم الآلي مقابل أمان البرامج التقليدية) يوفر فقط تحليلًا أمنيًا غير مكتمل للنظام ككل". "مثلما يقول المثل القديم: الأمن قوي بقدر قوة أضعف حلقاته".

يحتاج مطورو التعلم الآلي إلى الانتباه إلى تهديدات الخصومة

لسوء الحظ، لا يتخذ مطورو ومتبني خوارزميات التعلم الآلي التدابير اللازمة لجعل نماذجهم قوية ضد الهجمات العدائية.

"إن خط أنابيب التطوير الحالي هو مجرد ضمان أن نموذجًا تم تدريبه على مجموعة تدريب يمكنه التعميم جيدًا لمجموعة اختبار، مع إهمال حقيقة أن النموذج غالبًا ما يكون شديد الثقة بشأن البيانات غير المرئية (خارج التوزيع) أو التي تم تضمينها بشكل ضار في نمط طروادة مجموعة التدريب، التي توفر طرقًا غير مقصودة لتجنب الهجمات والهجمات الخلفية التي يمكن للخصم الاستفادة منها للسيطرة على النموذج المنشور أو تضليله". "من وجهة نظري، على غرار تطوير وتصنيع طراز السيارة، يجب أن يكون" اختبار الاصطدام الداخلي "الشامل لمختلف التعاملات العدائية على نموذج الذكاء الاصطناعي هو المعيار الجديد للممارسة لفهم المخاطر الأمنية المحتملة والتخفيف منها بشكل أفضل."

في عمله في IBM Research، ساعد Chen في تطوير طرق مختلفة لاكتشاف وتصحيح الثغرات الأمنية في نماذج التعلم الآلي. مع ظهور Adversarial ML Threat Matrix، ستضع جهود Chen وغيره من الباحثين في مجال الذكاء الاصطناعي والأمن المطورين في وضع أفضل لإنشاء أنظمة تعلم آلي آمنة وقوية.

يقول Chen: "آمل أن يتمكن مطورو النماذج وباحثو التعلم الآلي من خلال هذه الدراسة من إيلاء المزيد من الاهتمام لجانب الأمان (المتانة) للنموذج والنظر إلى ما وراء مقياس أداء واحد مثل الدقة".

"إن خط أنابيب التطوير الحالي هو مجرد ضمان أن نموذجًا تم تدريبه على مجموعة تدريب يمكنه التعميم جيدًا لمجموعة اختبار، مع إهمال حقيقة أن النموذج غالبًا ما يكون شديد الثقة بشأن البيانات غير المرئية (خارج التوزيع) أو التي تم تضمينها بشكل ضار في نمط طروادة مجموعة التدريب، التي توفر طرقًا غير مقصودة لتجنب الهجمات والهجمات الخلفية التي يمكن للخصم الاستفادة منها للسيطرة على النموذج المنشور أو تضليله". "من وجهة نظري، على غرار تطوير وتصنيع طراز السيارة، يجب أن يكون" اختبار الاصطدام الداخلي "الشامل لمختلف التعاملات العدائية على نموذج الذكاء الاصطناعي هو المعيار الجديد للممارسة لفهم المخاطر الأمنية المحتملة والتخفيف منها بشكل أفضل."

في عمله في IBM Research، ساعد Chen في تطوير طرق مختلفة لاكتشاف وتصحيح الثغرات الأمنية في نماذج التعلم الآلي. مع ظهور Adversarial ML Threat Matrix، ستضع جهود Chen وغيره من الباحثين في مجال الذكاء الاصطناعي والأمن المطورين في وضع أفضل لإنشاء أنظمة تعلم آلي آمنة وقوية.

يقول Chen: "آمل أن يتمكن مطورو النماذج وباحثو التعلم الآلي من خلال هذه الدراسة من إيلاء المزيد من الاهتمام لجانب الأمان (المتانة) للنموذج والنظر إلى ما وراء مقياس أداء واحد مثل الدقة".

تم نشر هذا المقال في الأصل بواسطة Ben Dickson على TechTalks، وهو منشور يبحث في الاتجاهات في التكنولوجيا، وكيف تؤثر على الطريقة التي نعيش بها ونؤدي أعمالنا، والمشكلات التي تحلها. لكننا نناقش أيضًا الجانب الشرير للتكنولوجيا، والآثار المظلمة للتكنولوجيا الجديدة وما نحتاج إلى البحث عنه.