في السباق لتقديم خدمات ذكاء اصطناعي توليدية جديدة ومحسنة، تحتاج شركات التكنولوجيا إلى وحدات معالجة مركزية جديدة للمساعدة في تشغيل العدد المتزايد من الخوادم اللازمة لتشغيل هذه الوظائف. لقد كانت NVIDIA، بلا شك، الرائدة في توفير هذه الأنواع من وحدات المعالجة المركزية لهذه الشركات، بما في ذلك Microsoft، وقد حققت أرباحًا طائلة نتيجة لذلك.

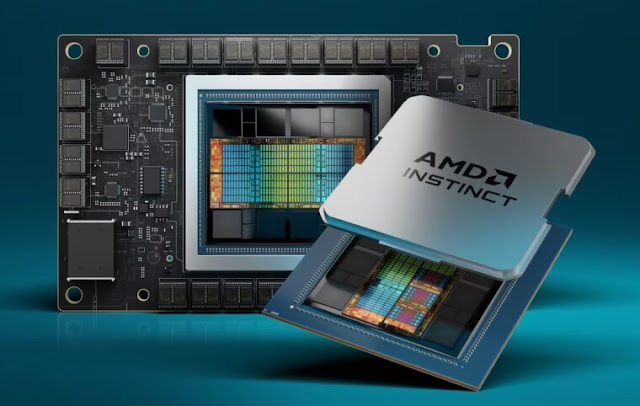

اليوم، أعلنت شركة AMD، أحد أكبر منافسي NVIDIA، عن خططها لتقديم أحدث إصدار من شرائح الذكاء الاصطناعي التوليدية الخاصة بها مع تقديم سلسلة AMD Instinct MI300. وكانت مايكروسوفت من بين الشركات التي قالت إنها ستستخدم إصدارات من رقائق AMD الجديدة في خدماتها. على وجه التحديد، قالت Microsoft إنها ستستخدم AMD Instinct MI300X في خوادم Azure ND MI300x v5 Virtual Machine الخاصة بها.

ذكرت AMD أن Instinct MI300X الجديد يستخدم بنية CDNA 3 الخاصة به. لقد قارنت أداءها بأداء وحدات معالجة الرسومات NVIDIA H100 التي تم استخدامها في العديد من الشركات لخدمات الذكاء الاصطناعي، بما في ذلك Microsoft:

اليوم، أعلنت شركة AMD، أحد أكبر منافسي NVIDIA، عن خططها لتقديم أحدث إصدار من شرائح الذكاء الاصطناعي التوليدية الخاصة بها مع تقديم سلسلة AMD Instinct MI300. وكانت مايكروسوفت من بين الشركات التي قالت إنها ستستخدم إصدارات من رقائق AMD الجديدة في خدماتها. على وجه التحديد، قالت Microsoft إنها ستستخدم AMD Instinct MI300X في خوادم Azure ND MI300x v5 Virtual Machine الخاصة بها.

ذكرت AMD أن Instinct MI300X الجديد يستخدم بنية CDNA 3 الخاصة به. لقد قارنت أداءها بأداء وحدات معالجة الرسومات NVIDIA H100 التي تم استخدامها في العديد من الشركات لخدمات الذكاء الاصطناعي، بما في ذلك Microsoft:

بالمقارنة مع Nvidia H100 HGX، يمكن لمنصة AMD Instinct تقديم زيادة في الإنتاجية تصل إلى 1.6x عند تشغيل الاستدلال على LLMs مثل BLOOM 176B4 وهو الخيار الوحيد في السوق القادر على تشغيل الاستدلال لنموذج معلمة 70B، مثل Llama2، على مسرع MI300X واحد؛ تبسيط عمليات نشر LLM على مستوى المؤسسات وتمكين التكلفة الإجمالية للملكية المتميزة.

وأضافت AMD أن Meta وOracle سيكونان من بين الشركات التي ستستخدم شرائح Instinct MI300X لخدمات الذكاء الاصطناعي التوليدية الخاصة بها.

يعد هذا مجرد أحدث مثال على الدفعة الجديدة لتوفير الكمية الهائلة من الطلب على وحدات معالجة الرسومات المستندة إلى الذكاء الاصطناعي. في الواقع، أعلنت شركة مايكروسوفت قبل بضعة أسابيع في Ignite 2023 أنها ستصنع شريحة الذكاء الاصطناعي الخاصة بها، وهي Azure Maia AI Accelerator. وسيتم استخدامه للمساعدة في تشغيل خدمات Microsoft Copilot وAzure OpenAI في وقت ما في أوائل عام 2024.